他的死亡再次引发人们对人工智能领域的道德反思

2024-12-24 08:25:45 · ChineseHeadlineNews.com · 来源: 环球人物杂志

他的死亡再次引发

人们对人工智能领域的反思。

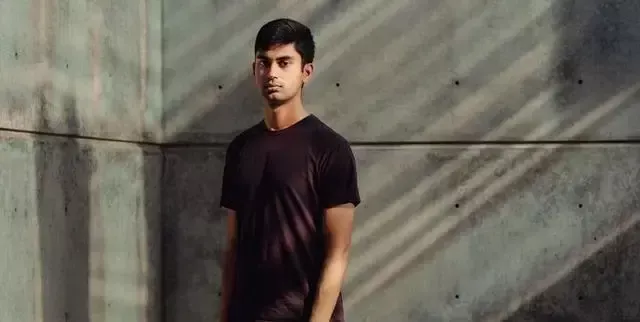

近日,一则消息掀起了科技圈的风浪:26岁的美国人工智能公司OpenAI前研究员苏奇尔·巴拉吉自杀身亡。

巴拉吉在OpenAI工作了近4年。生前,他揭露了OpenAI在训练其语言模型过程中存在可能违反美国版权法的行为,因此成为备受关注的“吹哨人”。

不仅如此,他还公开表达了对OpenAI的核心产品ChatGPT等在道德层面和行业生态方面的深切担忧。

如今,巴拉吉突然去世。虽然警方表示他大概率是自杀,但这无疑引发了人们对人工智能领域的反思。

毅然辞职

巴拉吉出生于1998年,是一名印度裔美国人,从小在加州长大。

在他上高中时,英国的人工智能公司深度思维(DeepMind)受到关注。该公司在人工智能领域有诸多突破性的研究成果,其中最为人所知的就是利用深度强化学习技术,训练AI玩电子游戏。

这深深吸引了巴拉吉。高中毕业后,他开始研究深度思维公司开发人工智能的底层逻辑——神经网络数学系统。

其间,他展现出对计算机科学的浓厚兴趣与天赋。在上大学时,他便选择了热爱的方向——加州大学伯克利分校计算机科学专业。

彼时,巴拉吉对人工智能的发展抱有很积极的态度,认为AI将会在医疗、抗衰等领域,帮助人们解决难题。

怀揣着早日踏入行业的心愿,巴拉吉四处寻找机会,先后在OpenAI和Scale AI进行实习,积累了不少经验。

毕业后,巴拉吉正式成为OpenAI的一名员工,在工作中与其他专业人员一起,深度探索如何训练AI模型,让其更好地形成逻辑思维。

随着研究越来越深入,巴拉吉意识到,人工智能快速发展的背后,蕴藏着一系列不合理的问题,与他的期待截然相反。

于是,在工作4年后,他毅然选择辞职。之后不久,他接受了《纽约时报》的采访,表达了自己辞职的原因和担忧。

巴拉吉认为,ChatGPT和其他类似的聊天机器人会破坏那些创建数字数据、内容的个人或组织的商业未来,而这些数据和内容已被广泛用于训练人工智能,“人工智能这项技术给社会带来的危害将大于益处”。

就在这番言论引发外界热烈讨论之时,传来了巴拉吉的死讯。美国消费者新闻与商业频道报道,当地时间11月26日,巴拉吉被发现在他位于旧金山的公寓内自杀身亡。

随后,旧金山首席法医办公室执行主任在一封电子邮件中证实了这一消息。

美国旧金山警察局称,11月26日下午,警察被叫到纽约布坎南街的一间公寓进行健康检查。在检查中,他们发现一名成年男性(即巴拉吉)已经死亡,初步调查并未发现任何他杀证据。

“吹哨人”

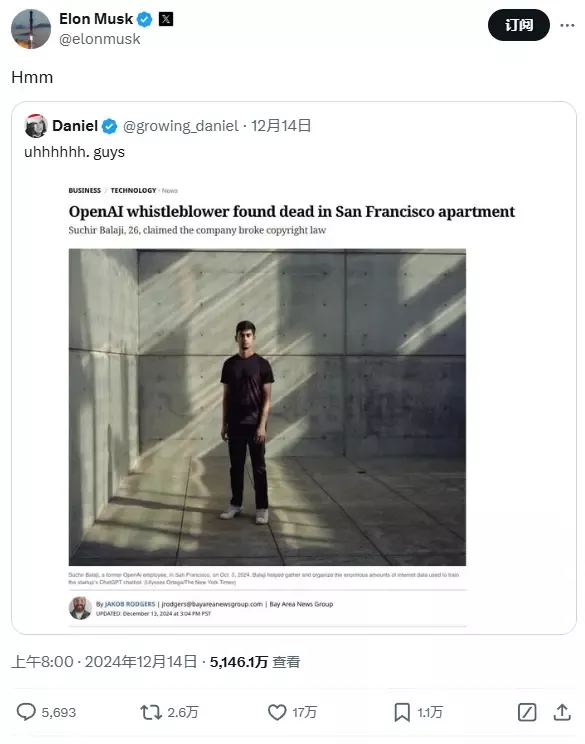

消息传出后,不少网友在社交媒体上表示哀悼和惋惜。正与OpenAI打官司的全球首富马斯克转发了相关报道,并配文:“唔(Hmm)。”

·马斯克转发巴拉吉的相关报道。

OpenAI公司的发言人对此表示:“今天得知这一令人难以置信的噩耗,我们感到非常悲痛,在这一艰难时刻,我们向巴拉吉的亲人表示同情。”

不过,一位巴拉吉的朋友对此事表示怀疑,“他很聪明,绝不像是会自杀的人”。

巴拉吉之死之所以引发圈内关注,不仅是因为《纽约时报》的采访,更是因为他在社交媒体上发布的控诉文。

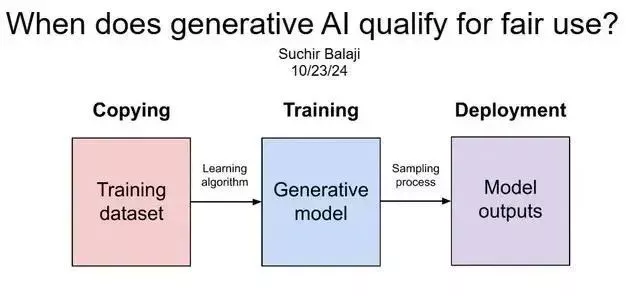

在这篇万字长文中,巴拉吉基于自己对业务的了解和研究,针对OpenAI备受争议的“先复制,后请求原谅”的版权做法,进行了揭露和批判。

巴拉吉指出,训练大型语言模型需要依靠海量的文本数据来进行学习与生成。OpenAI未经许可就抓取大量书籍、文章和网站的内容来训练ChatGPT,其中很多数据都来自于网络上受版权保护的内容。

巴拉吉称,OpenAI在使用这些未授权的材料训练模型时,没有充分遵循“合理使用原则”,涉嫌侵犯美国的版权法。

他在文章中引用了美国1976年《版权法》的相关规定,作出解释。

“合理使用”的判断标准通常有以下几条:非营利性教育使用通常更容易被认定为合理使用;事实性作品在合理使用中往往更具法律保护;使用较少的部分可能更容易被认定为合理使用;如果某一使用会取代原作品的市场,通常不被视为合理使用。

基于以上标准,巴拉吉进行了论证,并得出结论——随着AI模型的能力越来越强大,其输出的内容极有可能会与原始版权作品形成竞争关系。

例如,当用户需要一篇文章时,ChatGPT生成的内容可能会替代原创内容被使用,这将会挤压创作者的生存空间。 ·巴拉吉的相关论证。

·巴拉吉的相关论证。

因为上述披露,巴拉吉被称为针对OpenAI的“吹哨人”。

事实上,巴拉吉本人并不想针对OpenAI,而是希望警醒整个生成式AI行业。他在文章中也强调,“希望这不要被解读为对OpenAI本身的批评”。

很显然,OpenAI不这么认为。此文发出后,OpenAI立即向巴拉吉发出了起诉函。

就在收到起诉函的第二天,巴拉吉便发生悲剧。这距离他发出指控,还不到3个月。

OpenAI诉讼缠身

因为版权等问题,OpenAI近两年早已诉讼缠身。

2023年6月,作家保罗·特伦布莱和莫娜·阿瓦德对OpenAI提起集体诉讼,称ChatGPT未经授权使用其作品内容训练模型,违反联邦版权法;7月,喜剧演员莎拉·西尔弗曼等也起诉OpenAI,称未授权该公司使用其作品训练AI模型。

·莎拉·西尔弗曼。

《纽约时报》曾于2023年底起诉OpenAI和微软公司,指控这两家企业未经授权使用该媒体数以百万计的文章训练人工智能聊天机器人。

OpenAI当时做出过回应,在公司网站发布博客《OpenAI与新闻业》称:我们支持新闻业,与新闻机构合作,并认为《纽约时报》的诉讼毫无根据。

OpenAI表示,已经与数十家新闻机构以及新闻、媒体联盟等领先的行业组织会面,探讨机会,讨论他们的担忧,并提供解决方案,还声称“利用公开的互联网资料训练人工智能模型,属于合理使用”。

针对AI侵权问题,人工智能和数据合规律师胡颖涵对环球人物记者表示,创作者将作品发布在网站时,可以同步刊登版权说明,申明未经授权不得商用,还可以利用技术手段进行网络内容检测,及时发现潜在侵权行为。

除了外部诉讼,OpenAI也面临离职潮。不少员工离职后,公开表达了对OpenAI内部安全文化的担忧。

今年5月,OpenAI的一名AI策略研究员表示,由于感受到OpenAI存在巨大安全风险,她决定辞职。之后,OpenAI首席科学家伊尔亚正式宣布,他将离开公司去追求“下一个计划”。

OpenAI此前就被曝出,公司员工离职需签封口协议,“不签字就会影响股权”。

据员工披露,OpenAI在安全问题决策上不够透明,且缺乏对决策人的问责,同时公司内部对不同意见的包容度很低,可能导致风险的识别和管理被忽视。

根据美国《吹哨人保护法案》规定,联邦雇员在揭露组织内欺诈、非法或不当行为时遭到报复,如被保护对象因举报而受到降职、解雇等歧视性对待时,可向特别顾问办公室申诉,该办公室会展开调查并提供相应保护。

即便如此,有举报人向美国证券交易委员会投诉,OpenAI非法禁止员工向监管机构披露其技术可能对人类构成的严重风险,否则将受到离职、放弃补偿金等处罚。

这对那些想要表达担忧的员工形成了很强的威慑。

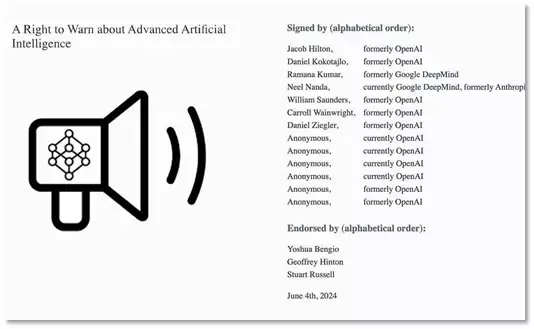

今年,OpenAI和谷歌旗下“深层思维”公司的13名现职员及前员工发表联名公开信,指出一般的法律保护对人工智能行业“吹哨人”而言“不够”,因为不少引人担忧的风险在法律监管方面仍属空白。

·OpenAI和谷歌旗下“深层思维”公司的13名现职员及前员工发表联名公开信。

其实,AI行业的潜在风险早已引起多国专家的关注。早前,英国网络科学专家温迪·霍尔与其他31位专家就在联合国机构发表报告,其中提到,人工智能技术应受到监管,如制定标准章程、建立监管机制等。

只有创作者、从业人员和政府机构一起努力,促进技术健康发展,才能真正避免下一场悲剧的发生。